Tin Tức Công Nghệ

Google Cloud Hợp Tác Cùng NVIDIA Để Hỗ Trợ Điện Toán AI

Google Cloud Next – Google Cloud và NVIDIA hôm nay đã công bố cơ sở hạ tầng và phần mềm AI mới dành cho khách hàng có thể xây dựng và triển khai các mô hình lớn cho khối lượng công việc khoa học dữ liệu tốc độ và AI tổng hợp.

NVIDIA Hỗ Trợ Các Cơ Sở Hạ Tầng Cho Google Để Phát Triện Khoa Học Dữ Liệu Và AI

Tại Google Cloud Next, Giám đốc điều hành Google Cloud Thomas Kurian và người sáng lập kiêm Giám đốc điều hành NVIDIA Jensen Huang đã thảo luận về cách thức hợp tác giúp các dịch vụ máy học toàn diện cho một số khách hàng AI lớn nhất trên thế giới. Nội dung bao gồm cả việc tạo ra nó siêu máy tính AI hoạt động tốt và dễ dàng với các dịch vụ Google Cloud được xây dựng trên công nghệ NVIDIA. Việc tích hợp phần cứng và phần mềm mới sử dụng cùng các công nghệ NVIDIA được Google DeepMind và nhóm nghiên cứu của Google sử dụng trong hai năm qua.

Huang chia sẻ rằng: “Chúng ta đang ở thời điểm chuyển tiếp, nơi điện toán tăng tốc và AI tổng hợp đã kết hợp với nhau để tăng tốc độ đổi mới với tốc độ chưa từng có”. “Sự cộng tác mở rộng của chúng tôi với Google Cloud sẽ giúp các nhà phát triển đẩy nhanh công việc của họ với cơ sở hạ tầng, phần mềm và dịch vụ giúp tăng cường hiệu quả sử dụng năng lượng và giảm chi phí.”

Kurian cho biết thêm: “Google Cloud có lịch sử lâu dài về đổi mới AI để thúc đẩy và tăng tốc độ đổi mới cho khách hàng của chúng tôi”. “Nhiều sản phẩm của Google được xây dựng và phục vụ trên GPU NVIDIA, đồng thời nhiều khách hàng của chúng tôi đang tìm kiếm điện toán tăng tốc NVIDIA để hỗ trợ phát triển LLM hiệu quả nhằm thúc đẩy AI sáng tạo.”

Tích Hợp NVIDIA Để Tăng Tốc Độ Phát Triển Khoa Học Dữ Liệu Và AI

Khung của Google để xây dựng các mô hình ngôn ngữ lớn (LLM), PaxML, hiện được tối ưu hóa cho điện toán tăng tốc NVIDIA.

Ban đầu được xây dựng để mở rộng nhiều phần tăng tốc Google TPU, PaxML hiện cho phép các nhà phát triển sử dụng GPU NVIDIA H100 và A100 Tensor Core để thử nghiệm và mở rộng quy mô nâng cao và có thể định cấu hình đầy đủ. Bộ chứa PaxML được tối ưu hóa cho GPU có sẵn ngay trong danh mục phần mềm NVIDIA NGC. Ngoài ra, PaxML chạy trên JAX, đã được tối ưu hóa cho các GPU tận dụng trình biên dịch OpenXLA.

Ngoài ra, các công ty đã công bố việc tích hợp Spark không máy chủ của Google với GPU NVIDIA thông qua dịch vụ Dataproc của Google. Điều này sẽ giúp các nhà khoa học dữ liệu tăng tốc và khối lượng công việc cho Apache Spark giúp chuẩn bị dữ liệu cho việc phát triển AI.

Đây là những tích hợp mới nhất trong lịch sử hợp tác lâu dài của Google và NVIDIA. Bao gồm cả phần cứng, phần mềm:

- Google Cloud trên các máy ảo A3 được hỗ trợ bởi GPU NVIDIA H100: Google Cloud đã công bố các máy ảo Google Cloud A3 được xây dựng có mục đích. Sử dụng GPU NVIDIA H100 sẽ ra mắt rộng rãi vào tháng tới, giúp nền tảng AI của NVIDIA dễ tiếp cận hơn cho nhiều khối lượng công việc khác nhau. So với thế hệ trước, máy ảo A3 có khả năng đào tạo nhanh hơn gấp 3 lần và băng thông mạng được cải thiện đáng kể.

- GPU NVIDIA H100 để hỗ trợ nền tảng Vertex AI của Google Cloud: GPU H100 dự kiến sẽ có mặt rộng rãi trên VertexAI trong những tuần tới, cho phép khách hàng nhanh chóng phát triển các LLM AI tổng hợp.

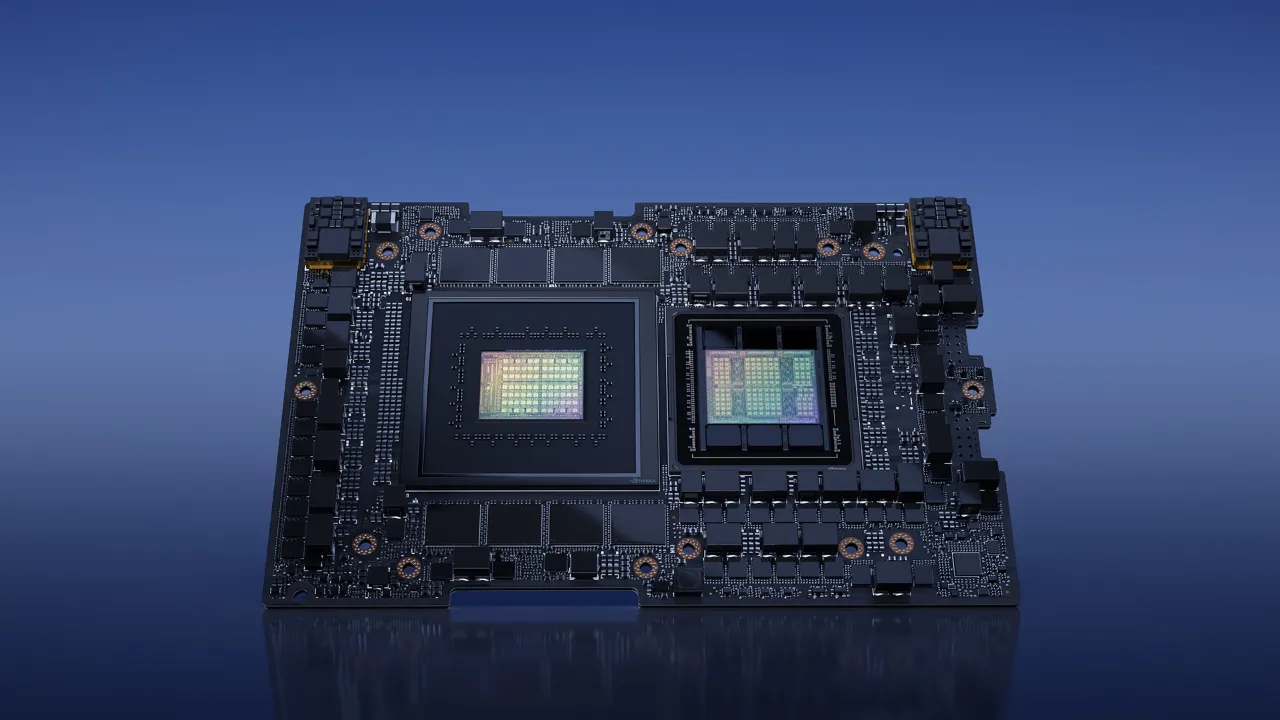

- Google Cloud để có quyền truy cập vào NVIDIA DGX GH200: Google Cloud sẽ là một trong những công ty đầu tiên trên thế giới có quyền truy cập vào siêu máy tính NVIDIA DGX GH200 AI. Được hỗ trợ bởi NVIDIA Grace Hopper Superchip, người dùng có thể khám phá các khả năng và tiềm năng của nó dành cho khối lượng công việc AI tổng hợp.

- NVIDIA DGX Cloud sắp có mặt trên Google Cloud: Siêu máy tính và phần mềm NVIDIA DGX Cloud AI sẽ có sẵn cho khách hàng trực tiếp từ trình duyệt web của họ để cung cấp tốc độ và quy mô cho khối lượng công việc đào tạo nâng cao.

- NVIDIA AI Enterprise trên Google Cloud Marketplace: Người dùng có thể truy cập NVIDIA AI Enterprise, một nền tảng phần mềm gốc đám mây, an toàn giúp đơn giản hóa việc phát triển và triển khai các ứng dụng sẵn sàng cho doanh nghiệp bao gồm AI tổng hợp, AI giọng nói, thị giác máy tính, v.v.

- Google Cloud lần đầu tiên cung cấp GPU NVIDIA L4: Đầu năm nay, Google Cloud đã trở thành nhà cung cấp đám mây đầu tiên cung cấp GPU NVIDIA L4 Tensor Core với sự ra mắt của G2 VM. Khách hàng của NVIDIA chuyển sang GPU L4 từ CPU cho khối lượng công việc video AI có thể nhận ra hiệu suất cao hơn tới 120 lần với hiệu suất tốt hơn 99%. GPU L4 được sử dụng rộng rãi để tạo hình ảnh và văn bản, cũng như chuyển mã âm thanh/video được tăng tốc VDI và AI.